270 words

1 minutes

【论文阅读笔记】Automatic Chain of Thought Prompting in Large Language Models

概要

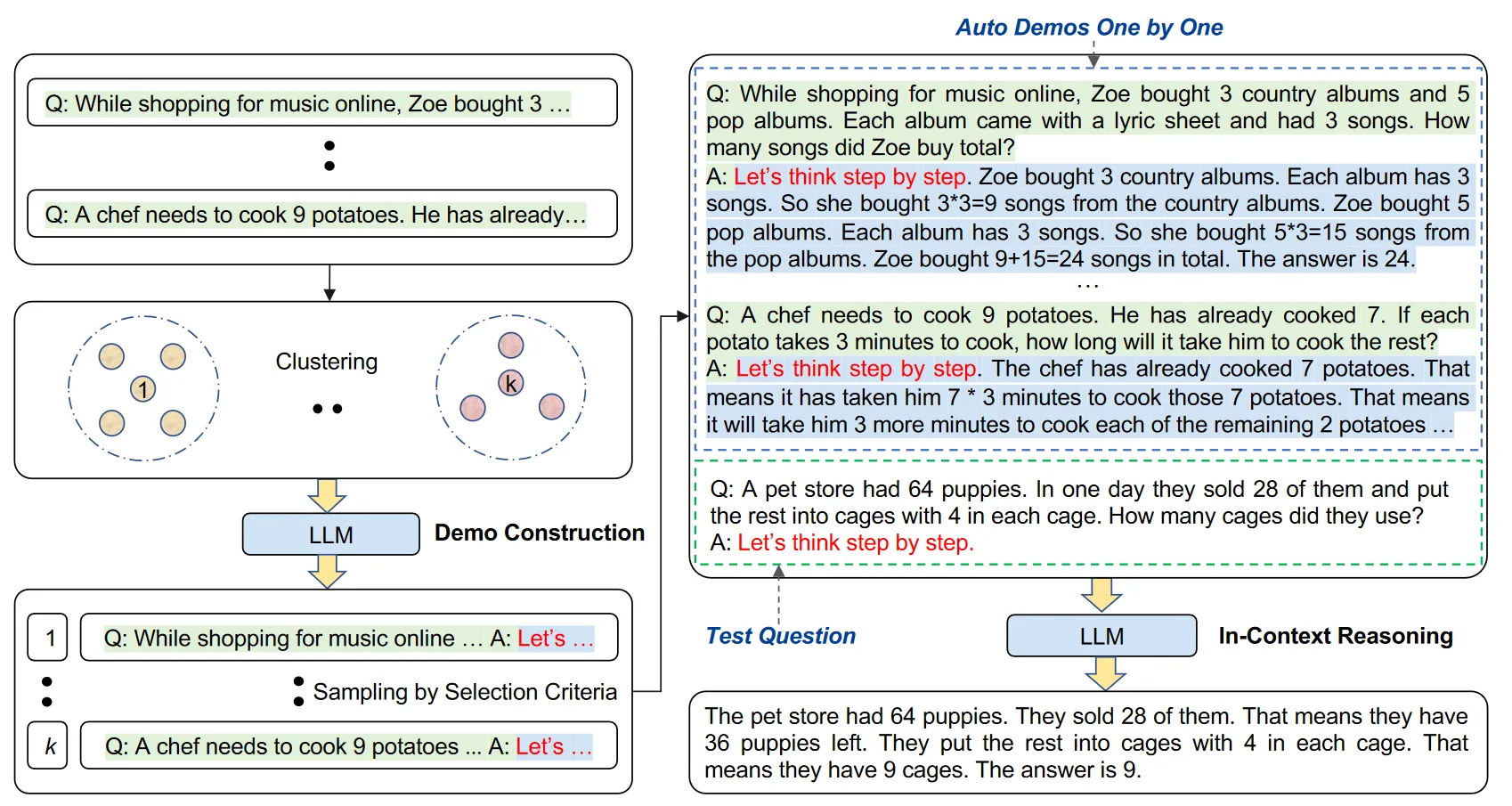

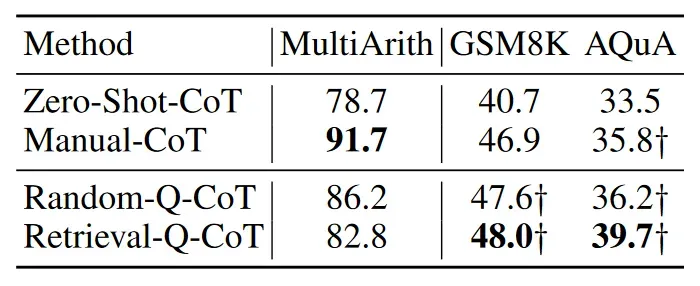

Auto-CoT的思路就是利用Zero-Shot-CoT来生成本来需要人工编写的Few-Shot-CoT(作者称为Manual-CoT)的prompt,同时匹配人工编写的准确度。 作者提出了Retrieval-Q-CoT和Random-Q-CoT两种方法,前者是从问题集合中检索与目标问题相似的问题进行demo construct,后者就是随机采样问题进行demo construct,得到结果如下:  发现Random-Q-CoT有概率超过Retrieval-Q-CoT,且Retrieval-Q-CoT在MultiArith测试集上与Manual-CoT差距较大,作者猜测是由于Zero-Shot-CoT在生成示例的时候仍然存在错误,而Retrieval-Q-CoT检索得到都是相似的问题,因此可能对目标问题的解答造成的负面影响。 最终作者采取的方法如下: 先在问题集合中用k-means聚类算法对问题向量进行聚类,从每个聚类中按照距离递增的顺序根据启发算法挑选一个问题用于生成示例。最后将k个示例和目标问题合成提示词喂给llm进行解答。

发现Random-Q-CoT有概率超过Retrieval-Q-CoT,且Retrieval-Q-CoT在MultiArith测试集上与Manual-CoT差距较大,作者猜测是由于Zero-Shot-CoT在生成示例的时候仍然存在错误,而Retrieval-Q-CoT检索得到都是相似的问题,因此可能对目标问题的解答造成的负面影响。 最终作者采取的方法如下: 先在问题集合中用k-means聚类算法对问题向量进行聚类,从每个聚类中按照距离递增的顺序根据启发算法挑选一个问题用于生成示例。最后将k个示例和目标问题合成提示词喂给llm进行解答。

【论文阅读笔记】Automatic Chain of Thought Prompting in Large Language Models

https://yinheee.pages.dev/posts/paper-reading/cot/automatic-cot/automatic-cot/